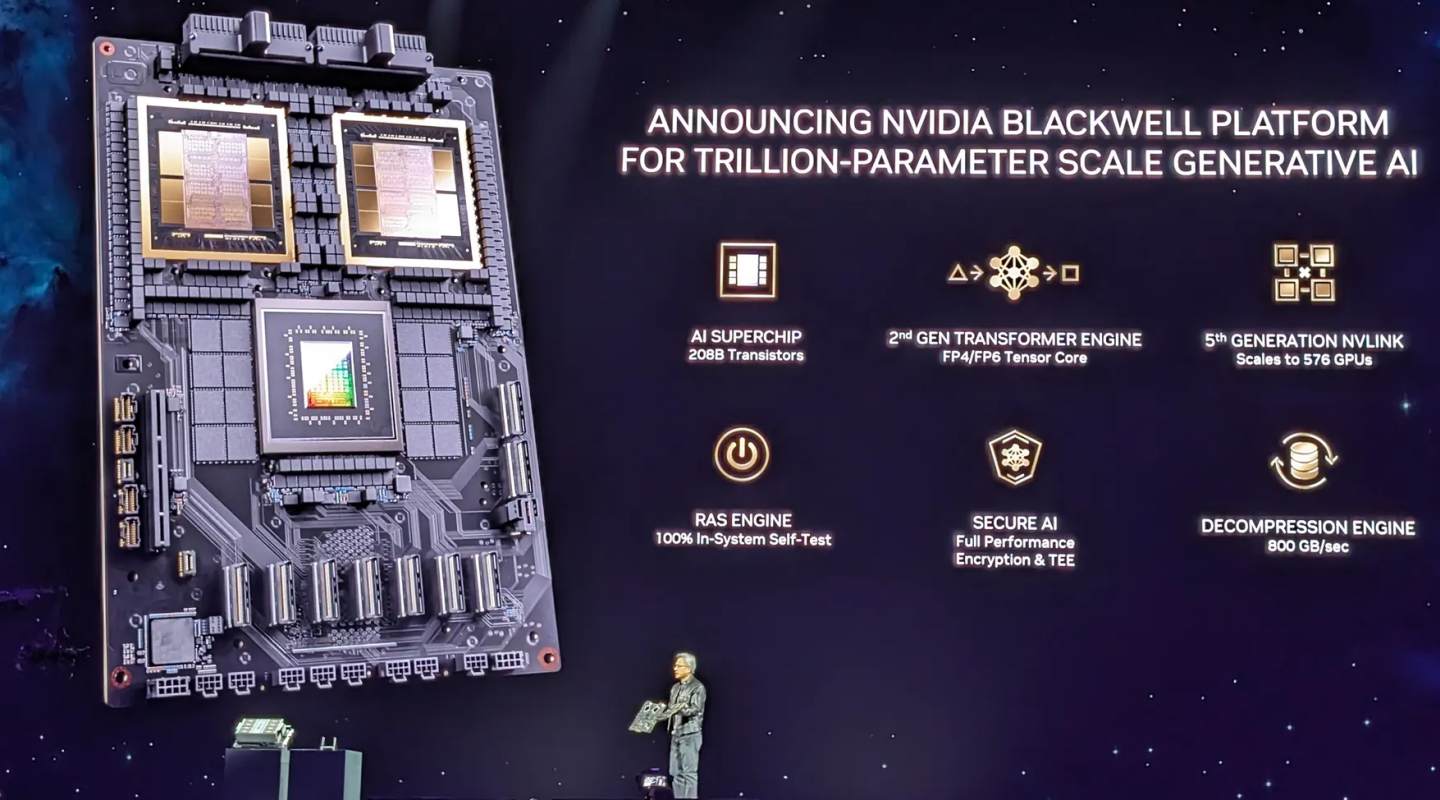

Nvidia 公司執行長 黃仁勳 於3月19日在 Nvidia GTC 2024 發表了全新的 Blackwell 晶片,承諾在 AI 效能和效率方面邁出一大步。

第一款 Blackwell「超級晶片」GB200 預計於今年稍後出貨,具備從單一機架擴充至整個資料中心的強大功能,而 Nvidia 則希望藉此在 AI 競賽中持續領先。

黃仁勳 指出,Blackwell 是公司硬體相較於前一代 Hopper 的重大進步,Blackwell 的兩個 GPU 晶粒包含 2,080 億個電晶體(高於 Hopper 的 800 億個),並透過每秒 10 TB 的晶片間鏈路連接成單一的統一 GPU。

這使得 Blackwell 在 AI 推論任務上比 Hopper 快上 30 倍,提供高達 20 petaflops 的 FP4 效能,遠遠領先於當今市場上的其他產品。

在主題演講中,黃仁勳 不僅強調了 Blackwell 和 Hopper 之間的巨大效能躍進,也強調了它們在尺寸上的顯著差異,他表示:「Blackwell 不是一顆晶片,而是一個平台的名稱。Hopper 非常棒,但我們需要更強大的 GPU。」

儘管如此快速,Nvidia 表示 Blackwell 可以將成本和能源消耗降低多達 25 倍,並舉例說明訓練一個 1.8 兆參數模型的案例,過去需要 8,000 個 Hopper GPU 和 15 兆瓦的電力,但現在僅需 2,000 個 Blackwell GPU,耗電量僅為 4 兆瓦。

新的 GB200 結合了兩個 Nvidia B200 Tensor Core GPU 和一個 Grace CPU,創造出公司簡稱為「大型超級晶片」的產品,能夠推動 AI 發展,提供比 H100 驅動系統高出 7 倍的效能和 4 倍的訓練速度。

會上該公司還展示了一款擁有 500 億個電晶體的下一代 NVLink 網路交換晶片,這意味著 576 個 GPU 能夠彼此通訊,創造出每秒 1.8 terabyte 的雙向頻寬。

Nvidia 已簽署多家主要合作夥伴來建置搭載 Blackwell 的系統,包括 AWS、Google Cloud、Microsoft Azure 和 Oracle Cloud Infrastructure,以及許多大型產業巨頭。